Googles Chatbot Bard beantwortet die Frage, wie viele Pandas in Zoos leben, schnell und selbstbewusst. Damit aber die Antworten richtig sind, benötigen sie eine vorgängige Prüfung – und die wird nach wie vor von Menschenhand gemacht. Grosse Techfirmen sind auf Menschen angewiesen, die die Antworten von KI überprüfen, Feedback zu Fehlern geben und jegliche Anzeichen von Voreingenommenheit ausmerzen.

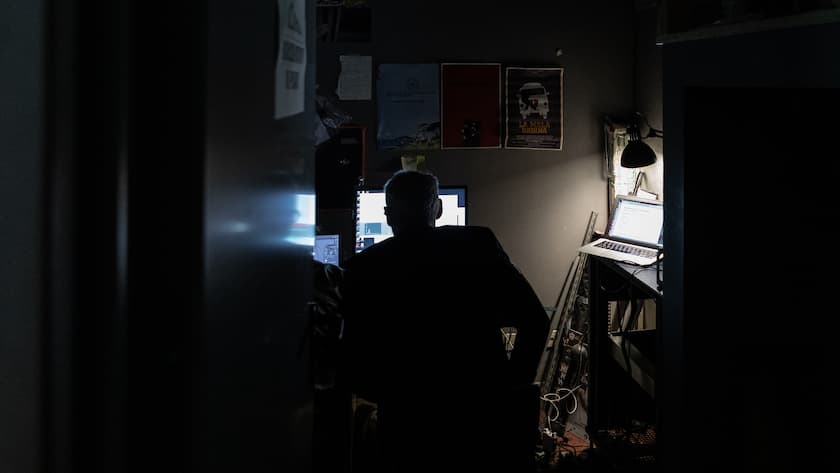

Die Leute, die diese Aufgaben übernehmen, sind externe Auftragnehmer, die auf Stundenbasis für Techfirmen arbeiten. Jetzt sickert durch: Ihre Arbeitsbedingungen lassen zu wünschen übrig. Minimale Ausbildung, hektische Fristen und ein Stundenlohn von 14 Dollar sind die Regel. Das bestätigen mehrere Arbeitnehmende gegenüber der Nachrichtenagentur Bloomberg.

Sechs derzeitige Google-Vertragsarbeiter sagten, dass mit dem Eintritt des Unternehmens in ein KI-Wettrüsten mit dem Konkurrenten Open AI im vergangenen Jahr die Arbeitsbelastung und die Komplexität ihrer Aufgaben zugenommen haben. Ohne spezifisches Fachwissen wurden sie mit der Bewertung von Antworten zu Themen betraut, die von Medikamentendosen bis hin zu staatlichen Gesetzen reichen. Dokumente, die Bloomberg zur Verfügung gestellt wurden, zeigen verworrene Anweisungen, die die Mitarbeiter bei ihren Aufgaben anwenden müssen. Dazu besteht ein Druck durch künstliche Fristen für die Prüfung der Antworten, die bis zu drei Minuten betragen können.

Kurze Prüfzeiten gefährden Genauigkeit von Google Bard

«So, wie es im Moment aussieht, sind die Leute verängstigt, gestresst, unterbezahlt und wissen nicht, was los ist», sagte einer der Auftragnehmer. «Und diese Kultur der Angst ist nicht gerade förderlich für die Qualität und die Teamarbeit, die man sich von uns allen wünscht.»

Privat und öffentlich haben die Auftragnehmenden Bedenken über ihre Arbeitsbedingungen geäussert. Ihrer Meinung nach beeinträchtigt der Druck auch die Qualität dessen, was schlussendlich die Nutzer sehen. Ein Google-Vertragsmitarbeiter, der für Appen arbeitet, sagte in einem Brief an den Kongress im Mai, dass die Geschwindigkeit, mit der die Auftragnehmenden Inhalte überprüfen müssen, dazu führen könnte, dass Bard ein «fehlerhaftes» und «gefährliches» Produkt werde.

Google hat künstliche Intelligenz zu einem Schwerpunkt gemacht, nachdem Open AI seinen Bot Chat GPT lanciert hatte. Bereits im November letzten Jahres lancierte Google seinen Konkurrenten Bard. Im Mai, auf der jährlichen Entwicklerkonferenz I/O, öffnete Google Bard für 180 Länder und Gebiete und stellte experimentelle KI-Funktionen in wichtigen Produkten wie Suche, E-Mail und Google Docs und Sheets vor. Google positioniert sich selbst als der Konkurrenz überlegen, weil es Zugang zu «dem gesamten Wissen der Welt» habe.

«Wir unternehmen umfangreiche Anstrengungen, um unsere KI-Produkte verantwortungsvoll zu entwickeln, einschliesslich strenger Tests, Schulungen und Feedback-Prozesse, die wir über Jahre hinweg verfeinert haben, um Sachlichkeit zu betonen und Voreingenommenheit zu reduzieren», gab Google in einer Erklärung bekannt. Das Unternehmen sagte, dass es sich nicht nur auf die Bewerter und Bewerterinnen verlasse, um die KI zu verbessern, sondern dass es eine Reihe anderer Methoden gebe, um die Genauigkeit und Qualität seiner Produkte zu verbessern.

Google verlangt «keinen strengen Faktencheck»

Um sich auf die Nutzung dieser Produkte durch die Öffentlichkeit vorzubereiten, haben die Mitarbeitenden nach eigenen Angaben bereits im Januar damit begonnen, KI-bezogene Aufgaben zu erhalten. Die Mitarbeitenden werden gebeten, die Fakten der KI-Antworten zu überprüfen. Dabei müssen sie ausserdem einschätzen, ob sie die Antwort als hilfreich empfunden haben. Das auf der Grundlage einer Sechs-Punkte-Richtlinie, die Analyse, Spezifität und Aktualität der Informationen sowie Kohärenz beinhaltet.

Zudem sollen sie sicherstellen, dass die Antworten keine «schädlichen, beleidigenden oder übermässig sexuellen Inhalte» und keine «ungenauen, trügerischen oder irreführenden Informationen» enthalten. Die Überprüfung der KI-Antworten auf irreführenden Inhalt sollte «auf der Grundlage Ihres aktuellen Wissensstandes oder einer schnellen Websuche» erfolgen, heisst es in den Richtlinien. «Sie müssen keinen strengen Faktencheck durchführen, wenn Sie die Antworten auf ihre Nützlichkeit hin überprüfen.»

Die Beispielantwort auf die Frage «Wer ist Michael Jackson?» enthielt eine falsche Angabe über die Hauptrolle des Sängers im Film «Moonwalker», der laut Bard 1983 veröffentlicht wurde. Tatsächlich kam der Film aber 1988 heraus. «Obwohl dies nachweislich falsch ist, ist diese Tatsache im Zusammenhang mit der Beantwortung der Frage ‹Wer ist Michael Jackson?› von geringer Bedeutung», heisst es in den Richtlinien.

Auch wenn die Ungenauigkeit gering zu sein scheint, «ist es dennoch beunruhigend, dass der Chatbot die wichtigsten Fakten falsch wiedergibt», sagt Alex Hanna, Forschungsdirektorin am Distributed AI Research Institute in Kalifornien und ehemalige KI-Ethikerin bei Google. «Es befeuert lediglich die Gefahr von Falschnachrichten», ergänzt sie.

Vorwürfe auch gegen Chat-GPT-Betreiber

Google bestritt die Vorwürfe, Mitarbeitende mit Warnsystemen vor Zeitüberschreitungen zu warnen. Gleichzeitig erklärte das Unternehmen, das nicht Google, sondern Appen für die Beurteilungen der Mitarbeitenden zuständig sei: «Unsere Zulieferer als Arbeitgeber legen die Arbeitsbedingungen fest, einschliesslich Bezahlung und Sozialleistungen, Arbeitszeiten und zugewiesene Aufgaben sowie Beschäftigungsänderungen – nicht Google.» Appen reagierte nicht auf Anfrage von Bloomberg. Ein Sprecher von Accenture sagte, das Unternehmen kommentiere die Arbeit seiner Kunden nicht.

Andere Technologieunternehmen, die KI-Produkte ausbilden, stellen auch menschliche Auftragnehmer ein, um sie zu verbessern. Im Januar berichtete das Magazin «Time», dass Arbeiter in Kenia für 2 Dollar pro Stunde daran gearbeitet hatten, Chat GPT zu «säubern». Andere Tech-Giganten wie Meta, Amazon und Apple setzen Subunternehmer ein, um Inhalte sozialer Netzwerke und Produktbewertungen zu moderieren und technischen Support und Kundendienst zu leisten.

(bloomberg/rul)